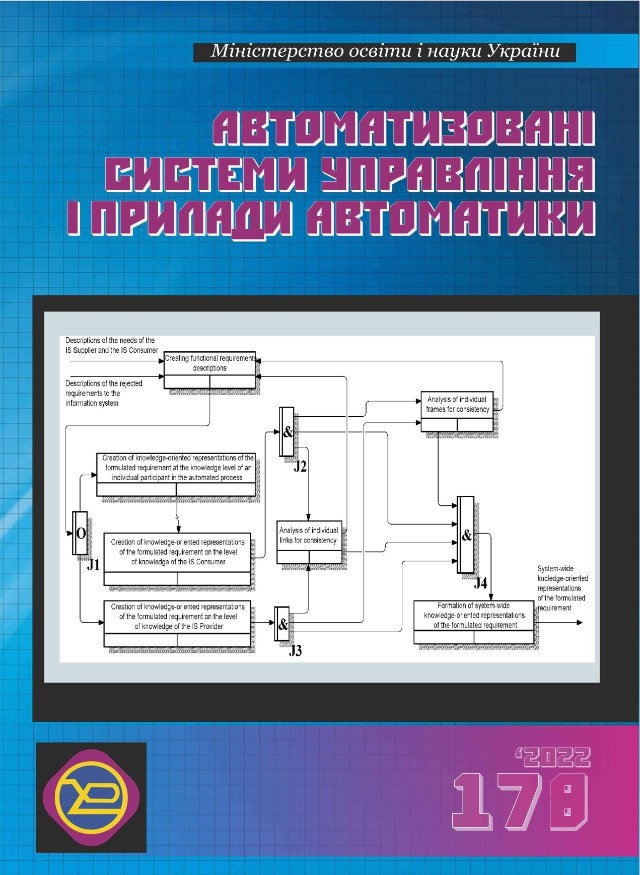

Процесний підхід до побудови моделі контексту пояснень в інтелектуальній інформаційній системі

пояснення

DOI:

https://doi.org/10.30837/0135-1710.2022.178.070Ключові слова:

пояснення, каузальні обмеження, темпоральні обмеження, артефактна модель, процесно-орієнтований методАнотація

Виконано структуризацію контексту пояснень в інтелектуальній інформаційній системі з урахування об'єктного та темпорального аспектів. Показано, що суттєві для пояснення знання визначають умови та обмеження у об'єктному та темпоральному аспектах щодо процесу прийняття рішень в інтелектуальній системі. Запропоновано артефактну модель контексту пояснень, яка містить опис артефактів предметної області та процесів обробки цих артефактів, що дає можливість персоналізувати пояснення з урахуванням їх актуальності на основі використання комбінації явних та неявних знань, які складають умови та обмеження щодо процесу прийняття рішення в інтелектуальній системі. Розроблено процесно-орієнтований метод побудови артефактної моделі контексту пояснень, який містить етапи формування множини артефактів, процесів обробки артефактів та залежностей, що лежать в основі цих процесів. Метод дає можливість сформувати опис контексту з використанням не лише явних, але й неявних знань.

Посилання

Miller T. Explanation in artificial intelligence: Insights from the social sciences. Artificial Intelligence. 2019. Vol. 267. P.1-38. DOI: https://doi.org/10.1016/j.artint.2018.07.007

Camburu O.-M., Giunchiglia E., Foerster J., Lukasiewicz T., Blunsom Ph. Can I trust the explainer? Verifying post-hoc explanatory methods. arXiv:1910.02065. 2019.

Castelvecchi D. Can we open the black box of AI? Nature. 2016.Vol. 538 (7623). P. 20-23.

Tintarev N., Masthoff J. A survey of explanations in recommender systems. The 3rd international workshop on web personalisation, recommender systems and intelligent user interfaces (WPRSIUI'07). 2007. P. 801-810.

Gunning D., Vorm E., Wang J., Turek M. darpa's Explainableai(xai) Program: a Retrospective. Applied AI Letters. 2021. Vol. 2. No. 4. https://doi.org/10.1002/ail2.61.

Pearl J. Causality: Models, Reasoning and Inference. 2nd ed. Cambridge University Press, USA. 2009.

Maier M., Marazopoulou K., Jensen D. Reasoning about Independence in Probabilistic Models of Relational Data. arXiv. 2014.

Marazopoulou K., Maier M., Jensen D. Learning the structure of causal models with relational and temporal dependence. Proceedings of the Thirty-First Conference on Uncertainty in Articial Intelligence. 2015.

Чала О.В. Модель узагальненого представлення темпоральних знань для задач підтримки управлінських рішень. Вісник Національного технічного університету "ХПІ". Системний аналіз, управління та інформаційні технології. 2020. № 1(3). С. 14-18. DOI: 10.20998/2079-0023.2020.01.03.

Chala O. Models of temporal dependencies for a probabilistic knowledge base. Econtechmod. An International Quarterly Journal. 2008. Vol. 7. No. 3. P. 53 - 58.

Чалий С.Ф. Реляційно-темпоральна модель набору сутностей предметної області для процесу формування рішення в інтелектуальній інформаційній системі / С. Ф. Чалий, В. О. Лещинський, І. О. Лещинська. Вісник Національного технічного університету "ХПІ". Сер. : Системний аналіз, управління та інформаційні технології = Bulletin of the National Technical University "KhPI". Ser. : System analysis, control and information technology : зб. наук. пр. Харків: НТУ "ХПІ", 2022. № 1 (7). С. 84-89.

Chalyi S., Leshchynskyi V. Temporal representation of causality in the construction of explanations in intelligent systems. Advanced Information Systems. Kharkiv: NTU "KhPI". 2020. Vol. 4. № 3. P. 113-117.

UA

UA  EN

EN