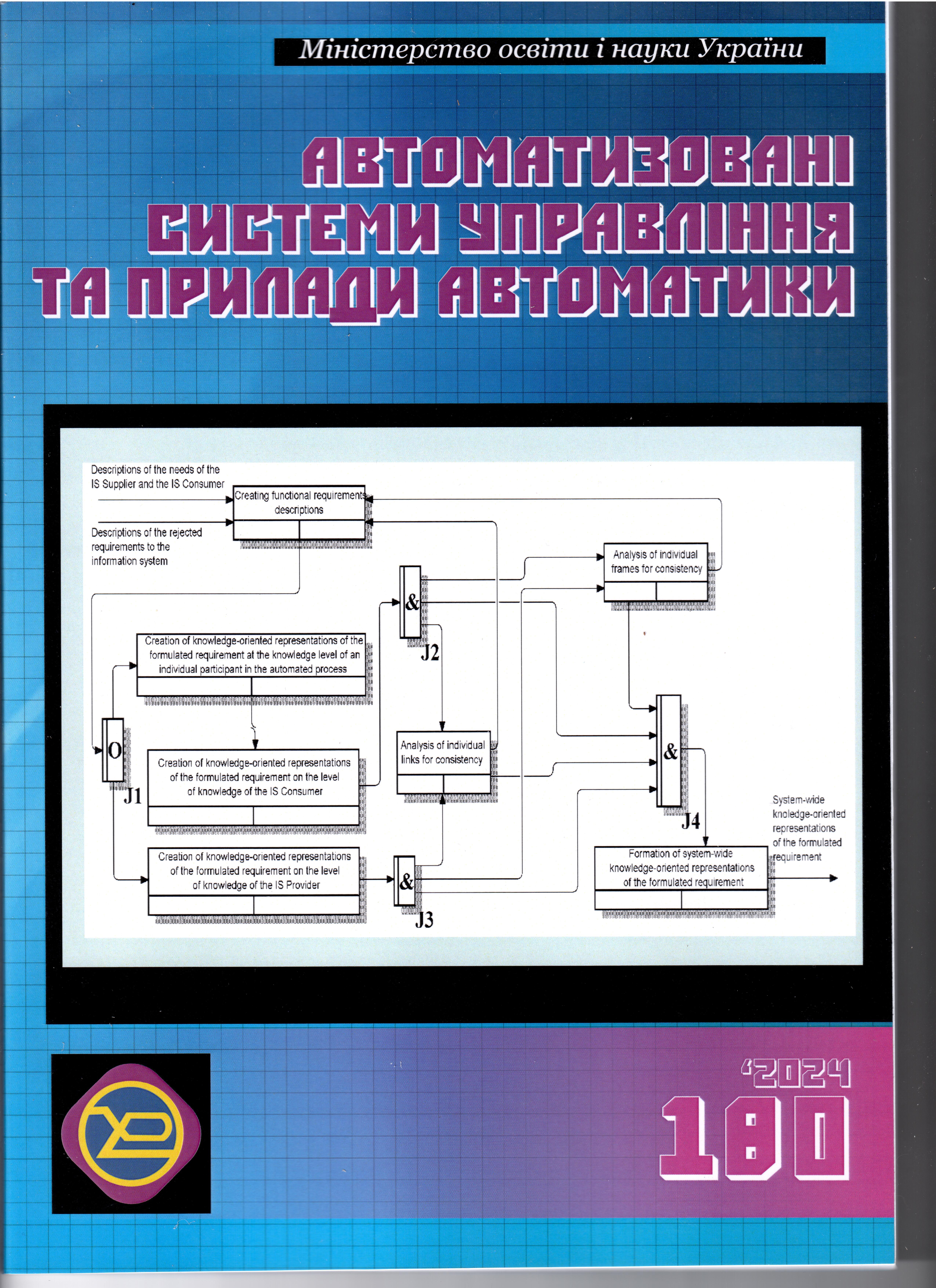

Метод формування заявок природною мовою на основі вдосконаленої моделі BERT

DOI:

https://doi.org/10.30837/0135-1710.2024.180.055Ключові слова:

послуга, заявка, BERT, лінійна регресія, байєсівський класифікаторАнотація

Об’єктом дослідження є процес формування заявок на отримання послуг. Під час створення інформаційних систем та інформаційних технологій автоматизованого управління послугами у різних предметних галузях постійно існує необхідність розвитку моделей, методів і алгоритмів, які могли б автоматизувати процес формування заявок на отримання послуг. Основні напрями досліджень у цій галузі пов’язані з використанням методів та моделей машинного навчання та обробки природної мови. Але подібні методи та моделі мають недоліки, які значно утруднюють застосування цих методів та моделей в інформаційних системах та технологіях, які автоматизують процес формування заявок на отримання послуг. Тому актуальним є дослідження, спрямоване на розробку методів і моделей, у яких ці недоліки усунені за рахунок комбінації відомих моделей і методів.

Як основу для розробки комбінованого методу формування заявки на отримання послуги обрано модель BERT. Для усунення її недоліків запропоновано застосовувати менш витратні методи машинного навчання. Розроблений комбінований метод складається з п’яти етапів: проведення аналізу текстового запиту з використанням моделі BERT; розрахунок вагових коефіцієнтів з використанням лінійної регресії; реалізація навченої моделі класифікації за допомогою методів машинного навчання; категоризація текстових описів з використанням моделі Байєса; надання рекомендацій користувачам системи.

Експериментальну перевірку розробленого комбінованого методу проведено на прикладі задачі формування та обробки заявок на отримання послуги з оренди автомобіля. Для розробки інформаційної технології використано мову Python та окремі бібліотеки, які дозволяють інтегрувати розроблену технологію до веб-сайту компанії. Отримані результати дозволяють стверджувати про доцільність використання розробленого комбінованого методу під час формування заявок у вигляді невеликих за обсягом текстів природною мовою користувачів.

Посилання

Horovitz J. Service Strategy: Management Moves for Customer Results. Pearson Education. 2004. 205 p.

ISO/IEC 20000-1:2018. Information technology – Service management – Part 1: Service management system requirements. 2018-09-14. 31 p.

Система управління замовленнями RemOnline. RemOnline. URL: https://remonline.ua/features/order-management/ (дата звернення 20.12.2023).

Huang M., Pang J. Research on the Evaluation System of Online Car Service Quality. Journal of Social Humanities. 2023. Vol. 5. Iss. 1. https://doi.org/10.53469/jssh.2023.5(01).09 .

Ling L. The Design of Multifunctional Online Travel Service Management Platform and the Implementation of MySQL. 2022 4th International Conference on Inventive Research in Computing Applications (ICIRCA). Coimbatore, India, 2022. P. 1293-1296. https://doi.org/10.1109/ICIRCA54612.2022.9985607.

Artificial Intelligence Powered Recommender as a Service. Recombee. URL: https://www.recombee.com/ (дата звернення: 18.12.2023).

Liang X., Kuang X., Xu Y. et al. The Construction of National Fitness Online Platform System under Mobile Internet Technology. International Journal of System Assurance Engineering and Management. 2021. Vol. 14. P.98-109. https://doi.org/10.1007/s13198-021-01198-5 .

Chang H., Shi T. Research and Design of a Job Service Platform Based on Recommendation Algorithm. The Frontiers of Society, Science and Technology. 2023. Vol. 5, iss. 14. P. 78-83. https://doi.org/10.25236/FSST.2023.051414

Enter the Era of Hyper-personalization with Experience OS. Dynamic yield. URL: https://www.dynamicyield.com/experience-os (дата звернення: 20.12.2023).

Amazon Personalize. AWS. URL: https://aws.amazon.com/personalize/ (дата звернення: 20.12.2023).

Battina D.S. Research on Artificial Intelligence for Citizen Services and Government. International Journal of Creative Research Thoughts. 2017. Vol. 5. Iss. 2. P. 769-773.

Devlin J., Chang M.-W., Lee K., Toutanova K. BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding. NAACL HLT 2019 – 2019 Conference of the North American Chapter of the Association for Computational Linguistics: Human Language Technologies – Proceedings of the Conference. Minneapolis, 2019. Vol. 1. P. 4171-4186.

Zhng Q., Ding L., Liu J., Du B., Tao D. Can ChatGPT understand too? A comparative Study on ChatGPT and Fine-tuned BERT. arXiv. https://doi.org/10.48550/arxiv.2302.10198 (дата звернення 22.12.2023).

Introducing ChatGPT Plus. OpenAI. URL: https://openai.com/blog/chatgpt-plus (дата звернення: 22.12.2023).

yang Z., Dai Z., Yang Y., Carbonell J., Salakhutdinov R., Le Q.V. XLNet: Generalized Autoregressive Pre-training for Language Understanding. NIPS’2019: Proceedings of the 33rd International Conference on Neural Information Processing Systems. Curran Associates inc., USA, 2019. Article No.: 517. P. 5753-5763. https://doi.org/10.48550/arXiv.1906.08237.

Liu Y. et al. RoBERTa: A Robustly Optimized BERT Pre-training Approach. arXiv. https://doi.org/10.48550/arXiv.1907.11692. (дата звернення 22.12.2023).

Lan Z., Chen M., Goodman S., Gimpel K., Sharma P., Soricut R. ALBERT: A Lite BERT for Self-supervised Learning of Language Representations. arXiv. https://doi.org/10.48550/arXiv.1909.11942 (дата звернення 22.12.2023).

Wang W., Bi B., Yan M., Wu C., Bao Z., Xia J., Peng L., Si L. StructBERT: Incorporating Language Structures into Pre-training for Deep Language Understanding. arXiv. https://doi.org/10.48550/arXiv.1908.04577 (дата звернення 22.12.2023).

Raffel C. et al. Exploring the Limits of Transfer Learning with a United Text-to-Text Transformer. arXiv. https://doi.org/10.48550/arXiv.1910.10683 (дата звернення 22.12.2023).

Brown T.B. et al. Language Models are Few-shot Learners. NIPS’20: Proceedings of the 34rd International Conference on Neural Information Processing Systems. Vancouver BC Canada, 2020. Article No.: 159. P. 1877-1901. https://doi.org/10.48550/arXiv.2005.14165 .

Clark K., Luong M.-T., Le Q.V., Manning C.D. ELECTRA: Pre-training Text Encoders as Discriminators Rather than Generators. arXiv. https://doi.org/10.48550/arXiv.2003.10555 (дата звернення 20.12.2023).

He P., Liu X., Gao J., Chen W. DeBERTa: Decoding-enhanced BERT with Disentangled Attention. arXiv. https://doi.org/10.48550/arXiv.2006.03654 (дата звернення 20.12.2023).

UA

UA  EN

EN